在最新的研究中,谷歌研究院利用自家的BIG-Bench基准测试,创建了一个名为 BIG-Bench Mistake 的专用基准数据集。该数据集旨在评估市面上流行的语言模型在 出错概率 和 自我纠错能力 方面的表现。

BIG-Bench Mistake数据集的建立

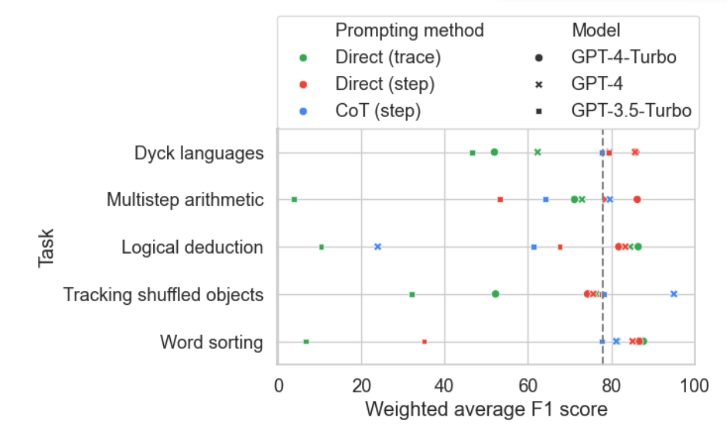

研究人员首先使用PaLM语言模型在BIG-Bench基准测试任务中运行了5项任务。随后,通过修改生成的 思维链 轨迹,加入 逻辑错误 部分,重新提交给模型,以判断思维链轨迹中存在哪些错误。通过多次反复进行这一过程,形成了一个包含 255项逻辑错误 的 BIG-Bench Mistake 专用基准数据集。

数据集的作用与优势

谷歌研究人员指出,由于该数据集中的逻辑错误相对 简单明确 ,它可以作为一个良好的测试标准,帮助语言模型从简单的逻辑错误开始练习,逐步提升辨识错误的能力。

测试结果与挑战

通过使用这一数据集对市面上的语言模型进行测试,研究人员发现大多数模型可以识别推理过程中的逻辑错误并进行自我修正。然而,这一过程并不够理想,通常需要人工干预来纠正模型输出的内容。谷歌声称 目前最先进的大语言模型 在自我纠错能力方面也相对有限,最好的模型仅找出了52.9%的逻辑错误。

改善自我纠错能力的建议

谷歌研究人员建议使用这一BIG-Bench Mistake数据集来改善模型的自我纠错能力。经过相关测试任务的微调后,即便是小型模型的表现通常也比零样本提示的大模型更好。因此,谷歌认为在模型纠错方面,使用专有小型模型来 监督 大型模型,相对于让大语言模型学会 纠正自我错误 ,部署专用于监督大模型的小型专用模型有利于改善效率、降低相关AI部署成本,并更便于微调。